Ho appena concluso la lettura del libro di ISIA Firenze “Il design nell’era della creatività artificiale” curato da Simone Aliprandi con interventi di varie figure operanti nella mia ormai ex università. Tra i vari contributi mi ha colpito particolarmente quello del Prof. Francesco Bonomi che, con il suo “Diventeremo tutti prompt engineer?”, ha espresso un pensiero che condivido attorno a un tema di cui mi sono indirettamente occupato durante il mio progetto di tesi, quello cioè del destino della UX/UI interface e del ruolo del designer a seguito della rivoluzione che le GenAI stanno introducendo nel mondo del tech.

O, in altri termini, se il prompt sia o meno il “killer” delle interfacce.

Ho riflettuto a lungo prima di scrivere questo articolo perché, in questi tempi, i pensieri invecchiano molto velocemente, risultando banali ancor prima di essere stati esplicati. Il ragionamento in questione risale in parte all’ormai “lontano” Novembre 2023, mese in cui sviluppavo il mio progetto di tesi. Tuttavia, girando per la rete e parlando con amici e conoscenti, soprattutto quelli che fieramente si definiscono “outsider dell’AI”, ho realizzato che il tema è ancora attualissimo. Ma questo non solo perché certe questioni che risultano ormai assodate per gli addetti al mestiere non lo siano di conseguenza per la maggior parte dell’utenza; quanto piuttosto per il fatto che, anche alla luce delle novità e dei progressi continui che scuotono di giorno in giorno questo mondo, mi sembra evidente che certe criticità restino tali e, dunque, siano meritevoli di attenzione.

Voglio dunque dare subito una risposta alla domanda che vi ho posto poco sopra: no, il prompt non è il “killer” delle interfacce, bensì una soluzione tecnica e temporanea, egregiamente mascherata.

Ma facciamo un piccolo salto indietro al 1978, anno in cui io, sicuramente, non ero neanche nei pensieri dei miei genitori, allora nel pieno della loro gioventù, mentre a Cupertino, Apple Computer Inc. era in procinto di rivoluzionare l’universo tecnologico pubblicando il suo primo sistema operativo: Apple DOS. Un sistema molto complesso e di nicchia che permetteva all’utente di scrivere del testo (input) e ottenere delle azioni (output). Mi ricorda qualcosa…

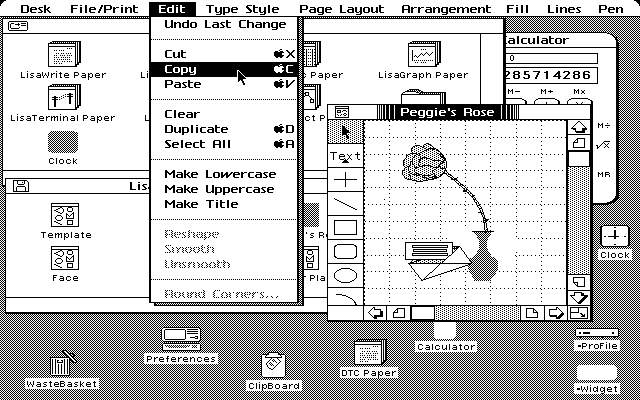

Pochi anni più tardi, nel 1983, usciva Apple Lisa, il primo sistema operativo di Apple con un’interfaccia utente che, grazie alla ormai naturale metafora della scrivania, fu una vera rivoluzione all’epoca.

L’azienda di Cupertino non aveva fatto altro che applicare il cosiddetto “Human-Centered Design” (HCD), un principio che ha plasmato la storia della tecnologia: la trasformazione di sistemi complessi in strumenti semplici e facilmente accessibili per chiunque. Apple aveva appena trasformato l’uso dei computer da strumenti per esperti a qualcosa che chiunque può usare, grazie a interfacce semplici e intuitive.

Torniamo ai giorni nostri, in cui siamo bombardati da continui strumenti di AI, guru dell’AI, articoli che definiscono il “prompt engineer” come la nuova competenza più richiesta e spot la cui narrazione si conclude con “Oggi puoi realizzare quello che vuoi, basta descriverlo”.

Insomma, da un certo punto di vista la grande promessa della GenAI è di realizzare nuovamente e all’ennesima potenza ciò che Apple ha fatto negli anni ‘80: trasformare l’uso dei computer da strumenti per esperti a qualcosa che chiunque può usare, chiunque sappia parlare la sua lingua nativa.

Poi, però, ti rendi conto che per ottenere un risultato decente devi avere una “laurea in scrittura del prompt” e tante ore libere per sperimentare.

L’inganno è che il prompt può sembrare un approccio aperto e flessibile, ma nella realtà, chiedere all’utente di scrivere è un’azione troppo generica e velatamente complessa. Da una parte, utilizzare il testo sembra quasi naturale: descrivo ciò che voglio e sembra avere una libertà infinita. Ma dall’altra, la lingua stessa crea problemi. L’ordine delle parole e le sfumature del significato introducono una serie di complessità. La verità è che tutti i principali sistemi di AI che abbiamo per ora non sono altro che delle fasi embrionali per testare questa “nuova” tecnologia. Ma ammettiamo anche che i futuri chatbot risolveranno i problemi delle tecnologie attuali, esaudendo effettivamente la promessa di comprendere a tutti gli effetti la nostra lingua, senza richiedere nessun tipo di competenza specifica all’utente. Cerchiamo, insomma, di non perderci in riflessioni destinate a divenire carta straccia al momento dell’uscita di GPT-5.

Lasciamoci, per un attimo, persuadere dagli annunci più recenti, annunci nei quali ci viene raccontato un futuro in cui neanche dovremo più scrivere.

I recenti aggiornamenti di OpenAI e di Google riguardo a, rispettivamente, GPT-4o e Project Astra, mostrano come le due grandi aziende stiano muovendosi, nel fronte AI, verso la realizzazione di un chatbot vocale super intelligente. Il web già paragona il nuovo modello di OpenAI a “OS-1” del film Her, per la sua componente emotiva estremamente “umana”, ma non ci vorrà molto perché raggiunga le capacità del J.A.R.V.I.S., il computer intelligente capace di tutto del celebre film Marvel.

Sembra quindi che il destino della UI/UX non sia dei migliori e che l’interazione uomo-macchina verrà semplificata e ridotta ad una naturale comunicazione verbale.

Ebbene no, purtroppo o per fortuna, non è così semplice. Credere che L’uomo riuscirà a risolvere tutti i suoi problemi con la comunicazione verbale, significa non rendersi conto di quello che effettivamente ‘fa’ un interfaccia UX/UI. L’essere umano, infatti, ha più difficoltà a comunicare verbalmente rispetto che a interagire con il classico sistema grafico di segni e simboli. Più specificamente, l’utente non ha sempre chiara la domanda o azione (input) che deve fare perché spesso i flussi operativi hanno origine dalle suggestioni proprio di quel sistema visivo che andrebbe pian piano a perdersi.

Insomma: il problema non sta nella tecnologia, ma nell’utente. Come sostiene Bonomi, infatti: “Si potrebbe pensare che, con il progredire della tecnologia, questo problema si risolverà automaticamente perché avremo delle AI “perfette” che comprenderanno veramente il linguaggio naturale e basterà parlare “come ci viene” perché la AI risolva il problema che le esponiamo…A ben vedere, invece, è l’utente che spesso non sa esporre in modo adeguato i propri problemi. E qui le AI non c’entrano; succede lo stesso fra esseri umani.”

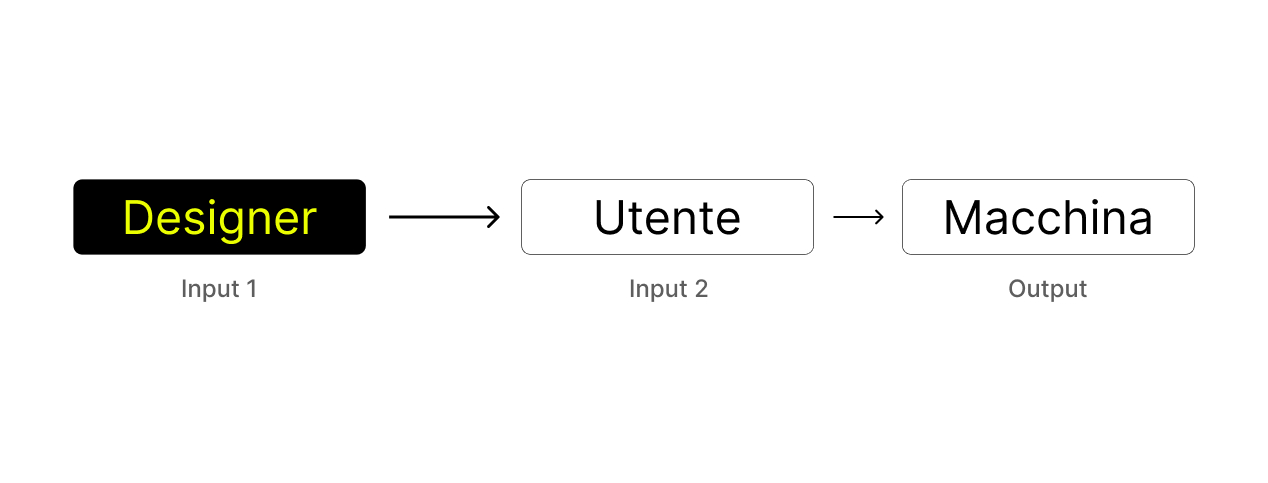

Con l’avvento dell’intelligenza artificiale, si sente sempre più spesso parlare di input/output riferendosi al prompt (input) e alla “creazione” della macchina (output). Tuttavia, questo rapporto diretto tra utente e macchina porta spesso a trascurare un elemento fondamentale: l’input del designer. Sebbene possa sembrare assente durante l’interazione tra utente e AI, il contributo del designer è cruciale. Il designer, infatti, progetta i sistemi di interfaccia utente (UI) e di esperienza utente (UX) – pulsanti, azioni, layer, ecc. – che conferiscono la suggestione e l’aiuto necessario all’utente nelle sue azioni.

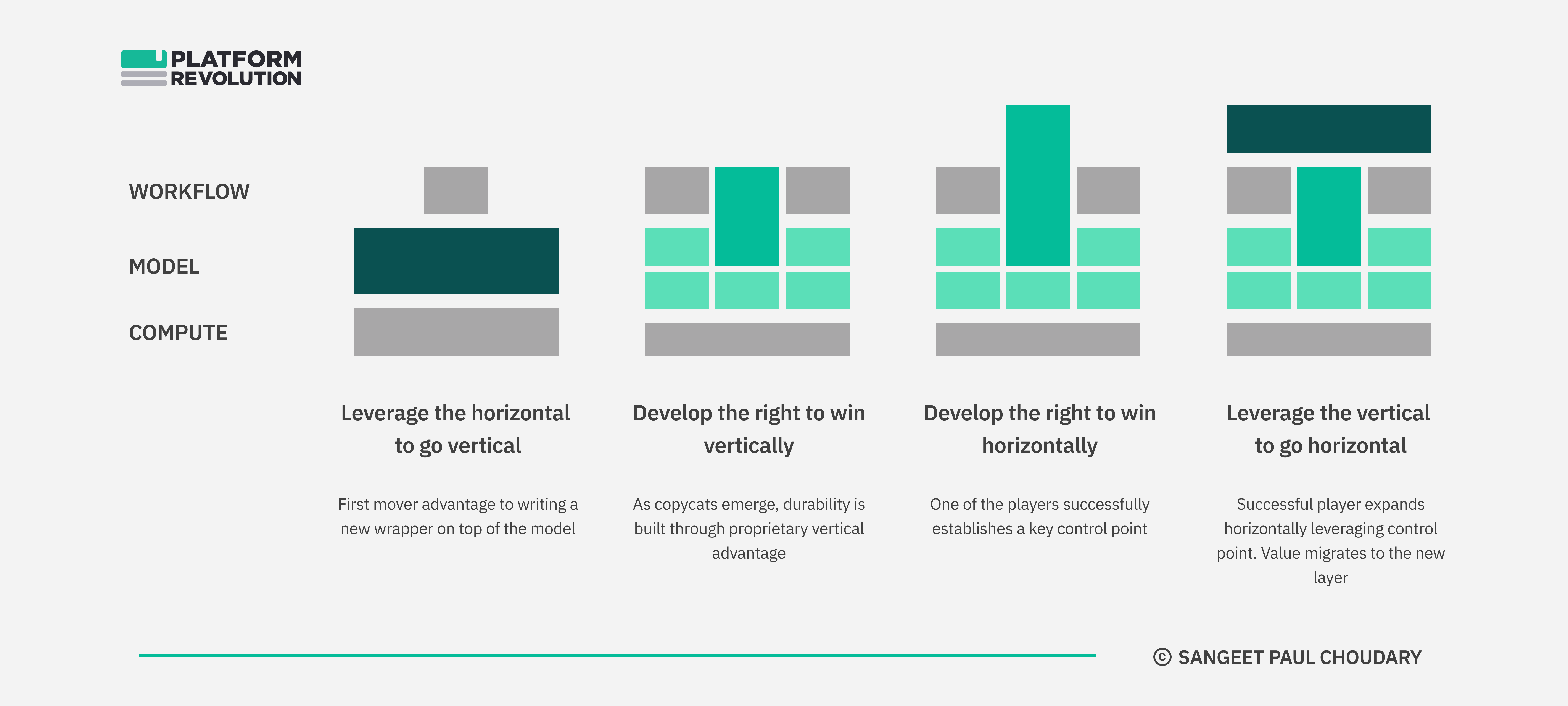

Qui scaturisce il ruolo del designer e l’importanza che assume all’interno del mercato dell’AI, perché sicuramente senza il motore la macchina non può muoversi, ma senza la macchina, l’utente non può utilizzare il motore. In sostanza nello scenario delle AI è importante la tecnologia, in questo caso parliamo di Foundation Model, tanto quanto l’involucro necessario per utilizzarla, il Wrapper. Con questo non voglio sostenere che ogni Wrapper sia necessario, e anzi quanto mai vero il contrario: negli ultimi mesi il web si è letteralmente riempito di copycat inutili e destinati a finire nel dimenticatoio. A tal proposito, segnaliamo un’ottima disamina di Sangeet Paul Choudary che identifica gli ingredienti che permettono ad un Wrapper di distinguersi, crescere e, con le parole di Choudary, ‘vincere la corsa delle AI generative’.

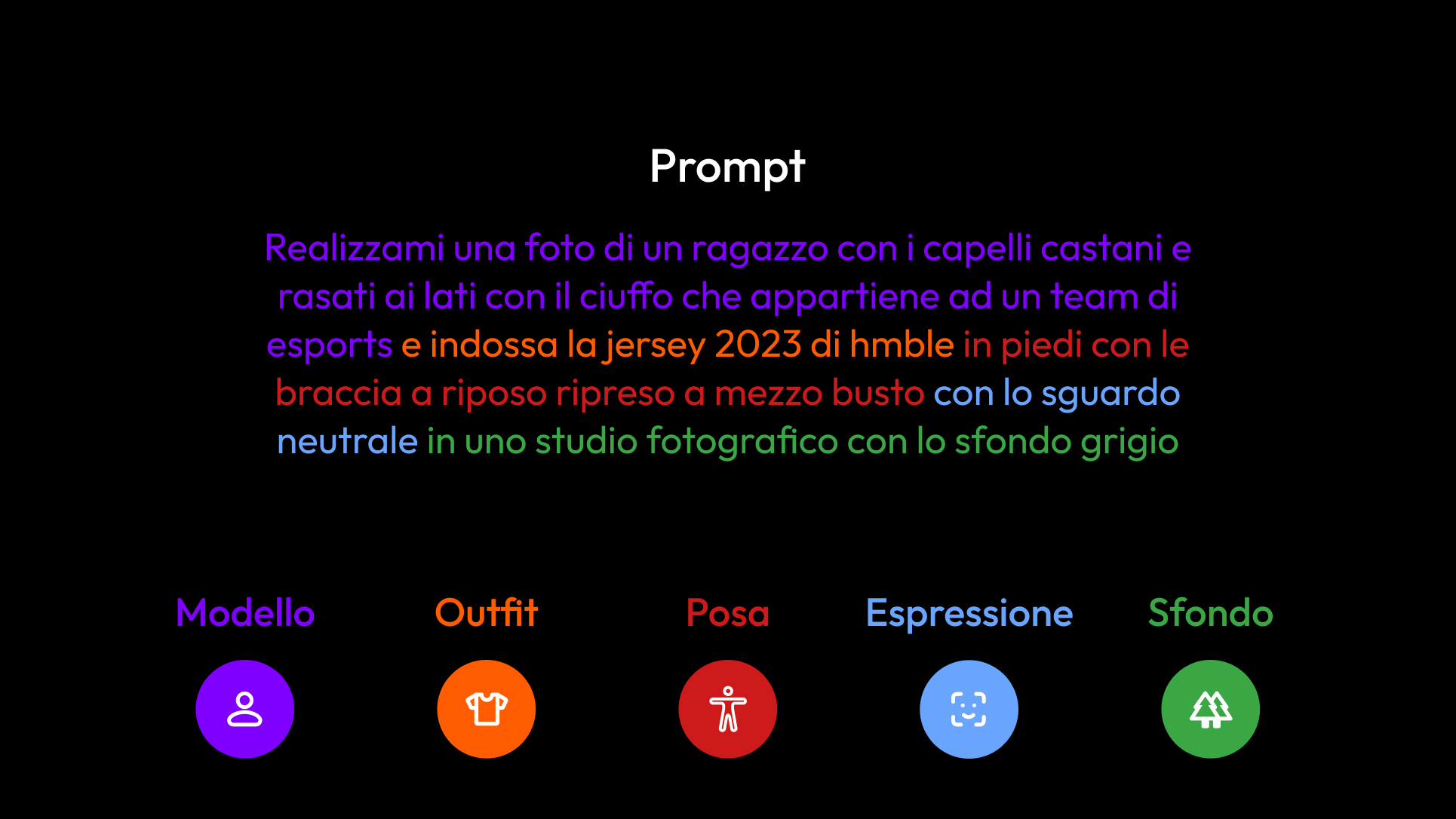

Nel mio progetto di tesi – Aracne – fra le altre cose, ho progettato un sistema per realizzare fotografie lifestyle per e-commerce, social network e qualsiasi altro media nel campo del fashion. Nella sua ideazione ho sfruttato la settorializzazione dello strumento che ha il solo compito di creare foto “

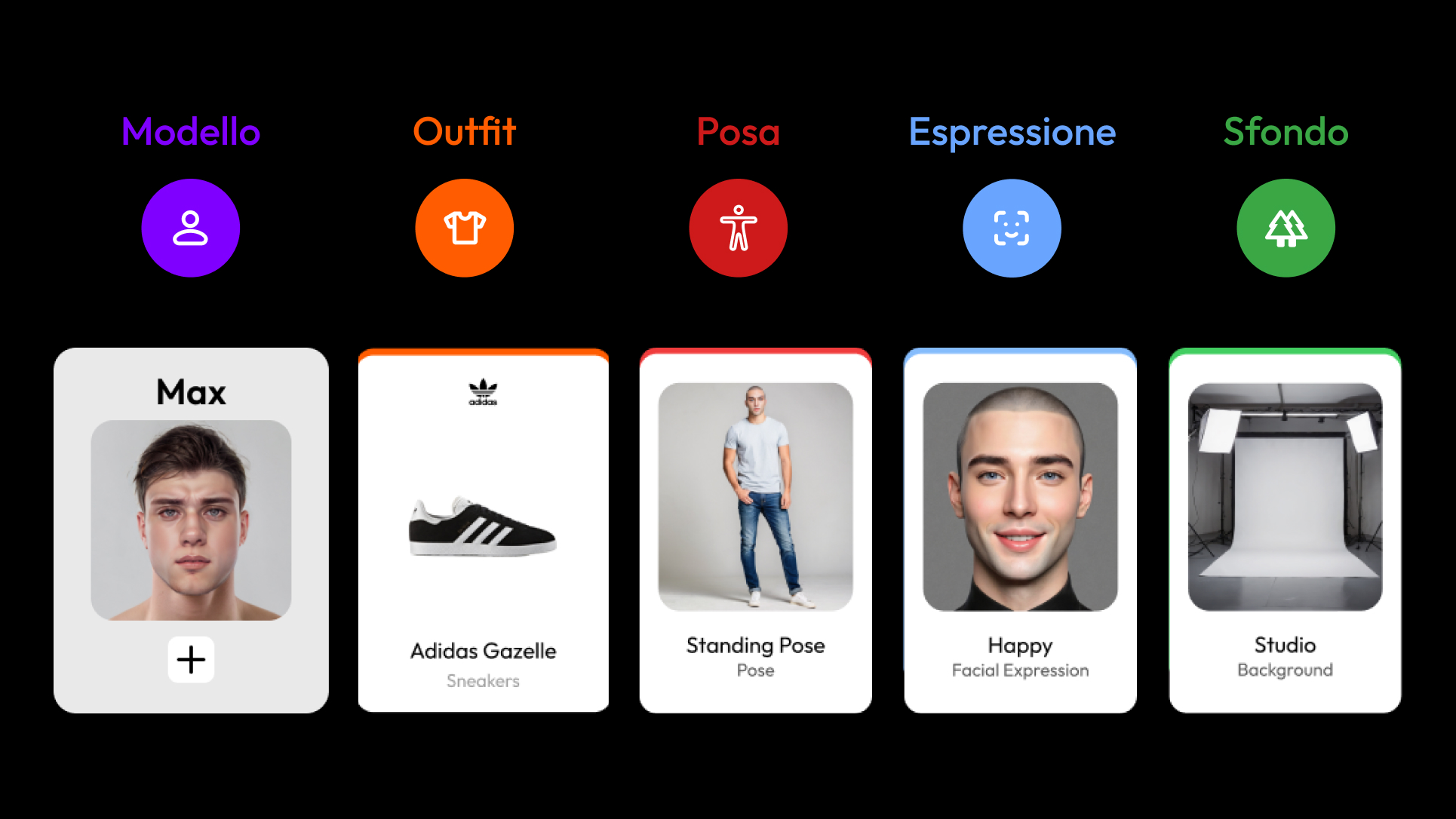

” per il fashion. Ho notato, infatti, che i prompt utilizzati per realizzare questo genere di immagini avevano in comune alcune caratteristiche: il modello, l’outfit, l’espressione facciale, la posa e lo sfondo.

Al che ho creato un sistema visivo di selezione basato su carte interattive, che guida gli utenti in modo intuitivo attraverso il processo di creazione. La comunicazione visiva è immediata, universale, già familiare grazie a tanti altri sistemi che usiamo ogni giorno. Con le carte, l’utente è guidato graficamente nella selezione di sfondi, pose, espressioni, stili, etc. senza dover navigare la complessità del linguaggio scritto dei prompt.

In conclusione , il prompt non è altro che uno stratagemma apparentemente semplice e flessibile ma di passaggio; la tecnologia sta avanzando come mai prima d’ora e c’è un grande bisogno di creare sistemi per ordinarla così da poter essere utilizzata correttamente ed efficacemente. Ma per quanto tempo questi sistemi potranno permettersi ancora di essere semi-statici? E siamo pronti ad immaginare interfacce dinamiche ed estremamente personalizzate? A ben vedere, quindi, la vera questione riguarda la natura di questi sistemi.