1. L’Alba di una Nuova Era: La Rivoluzione della GenAI

Dopo circa un anno dalla sua apparizione commerciale, possiamo affermare che l’intelligenza artificiale generativa (GenAI) è destinata a ridisegnare il mondo che ci circonda. Il suo impatto sulla società si annuncia tanto profondo e vasto che sarebbe riduttivo considerarla una mera innovazione. Questa rivoluzione tecnologica promette di influenzare una vasta gamma di settori in modo trasversale, dall’industria manifatturiera al cinema, dalla medicina alle arti visive, fino al settore specifico di cui tratta questo articolo: l’industria della moda. L’aspetto veramente rivoluzionario dell’intelligenza artificiale generativa sta nella sua capacità di essere applicata universalmente a qualsiasi settore, grazie a un requisito fondamentale che è alla portata di tutti: i dati. Questo requisito, essenziale e onnipresente, fa sì che l’innovazione portata dalla GenAI non sia limitata a nicchie specifiche, ma possa estendersi a modificare ogni aspetto del mondo che ci circonda. I dati, il ‘nuovo carbone’ del ventunesimo secolo, sono la risorsa chiave che alimenta questa trasformazione, rendendo l’intelligenza artificiale generativa un’innovazione veramente universale, capace di impattare trasversalmente una vasta gamma di settori.

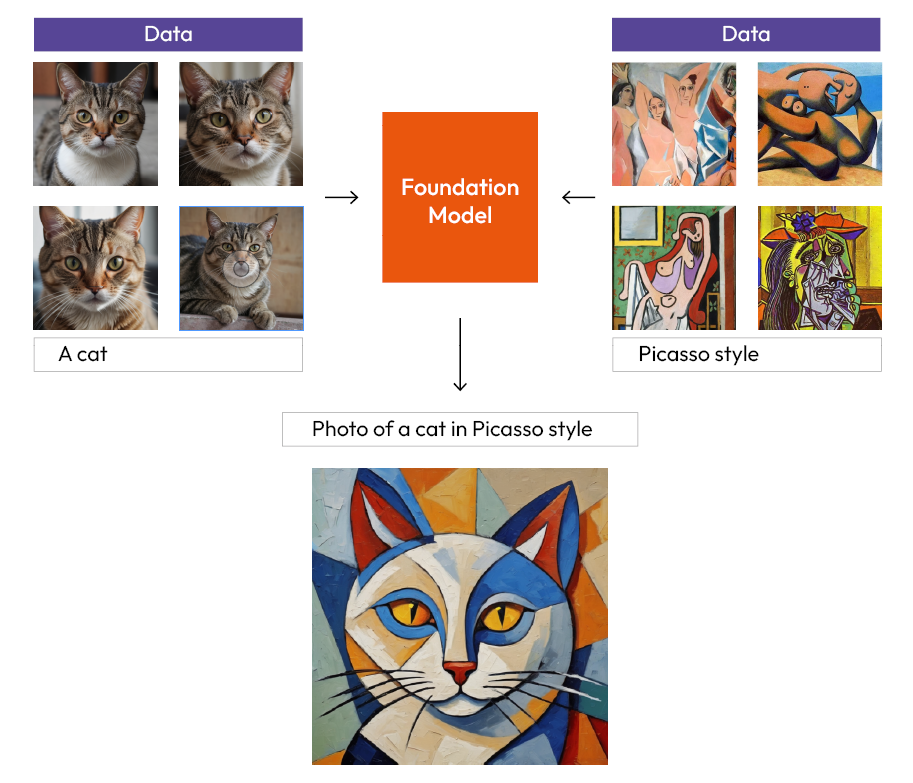

Le AI Generative emergono attraverso un processo denominato “training”, che consiste nell’addestramento della macchina, analogamente a come un genitore (o un tutore) guida un bambino nell’apprendimento del mondo circostante. Questo processo implica la preparazione di vasti set di dati (dataset), che servono a insegnare all’AI determinati concetti, portando alla creazione di ciò che nel gergo tecnico è noto come Modello Fondazionale (Foundation Model), il “cervello” della GenAI. Internet si rivela una fonte inesauribile per questo scopo, e grazie all’enorme quantità di dati caricati, condivisi e raccolti nei primi trent’anni di vita del World Wide Web (WWW), sono stati addestrati i primi grandi modelli di intelligenza artificiale generativa, come GPT, Stable Diffusion, ecc.

In sostanza, un Foundation Model è un’architettura di Reti Neurali Artificiali (ANN) addestrata a riconoscere schemi all’interno di vasti quantitativi di dati e a generare nuovi contenuti in vari formati, come testo, immagine e audio. Un modello fondazionale è versatile e capace di svolgere svariate funzioni, sebbene in modo generico e senza l’acume tipico di un vero esperto.

2. Fine-Tuning: Affinamento e Personalizzazione nella GenAI

Di fatto il modello di fondazione può essere a sua volta affinato (fine-tuned) aprendo vie pressoché infinite a qualsivoglia tipo di personalizzazioni. In pratica, è possibile, partendo da un foundation model (addestrato su milioni di dati), creare variegati sottomodelli ottimizzati nel generare un certo tipo di immagine. Il foundation model, di fatto, pur sapendo manipolare al meglio il prompt attraverso il cosiddetto “prompt engineering”, non permette di ottenere qualsivoglia risultato.

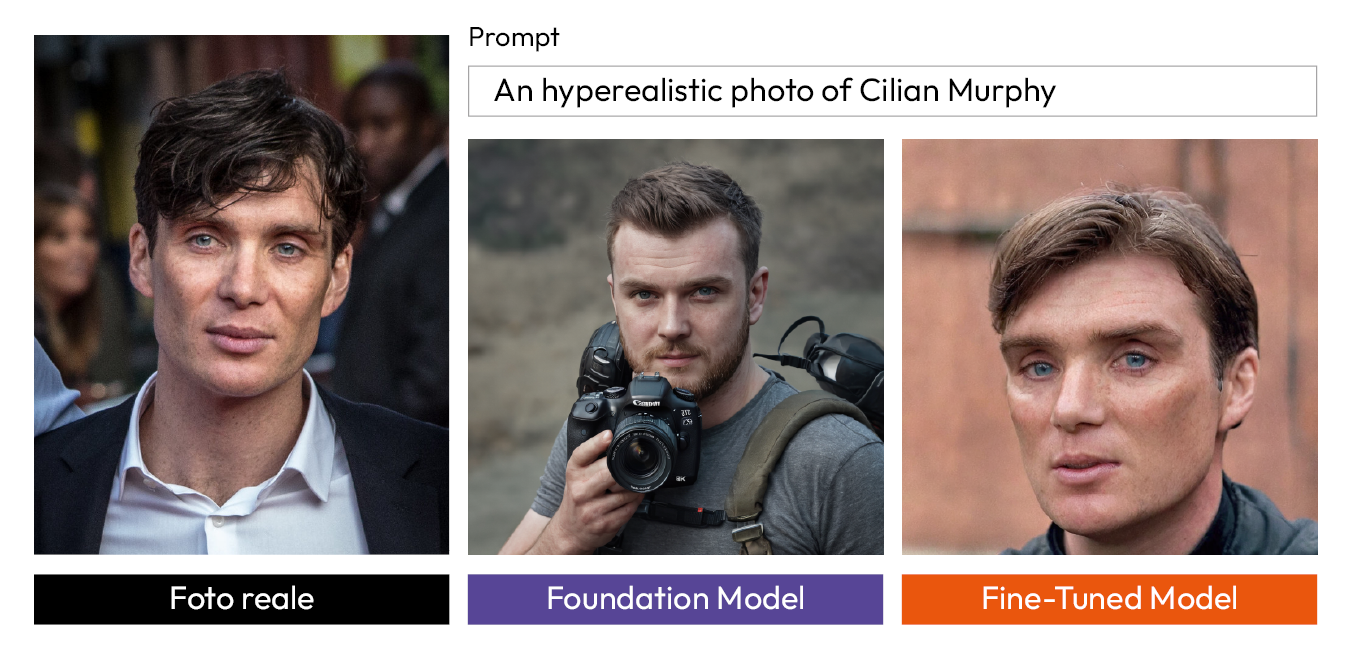

Infatti, se chiediamo al modello base una foto del noto attore Cilian Murphy, lui genererà una persona che con l’attore ha in comune solo i tratti del genere maschile, se invece proponiamo lo stesso prompt al modello affinato sul volto di Murphy otterremo una riproduzione verosimile dell’attore.

Il processo di fine-tuning di una GenAI non è facile e immediato come può sembrare: non basta semplicemente fornire alla rete un ulteriore database di dati per renderla specializzata su di essi. Le ricerche hanno dimostrato infatti che una rete neurale che viene ri-addestrata su un nuovo campione di dati rischia di incorrere in diversi problemi, fra tutti, l’overfitting e il catastrophic forgetting. Nel primo caso, la rete neurale non riesce ad integrare e contestualizzare i nuovi dati su cui è stata addestrata, concentrandosi eccessivamente su determinati dettagli poco rilevanti e trascurando le salienze più pregnanti, smette in pratica di funzionare in maniera soddisfacente. Nel secondo caso, invece, dimentica drammaticamente quello che aveva appreso nell’addestramento originale! Per questo motivo il processo di ottimizzazione di una GenAI può avvenire solo attraverso specifiche strategie e soluzioni ingegneristiche che cercano di perfezionare il modello evitando i problemi sopracitati.

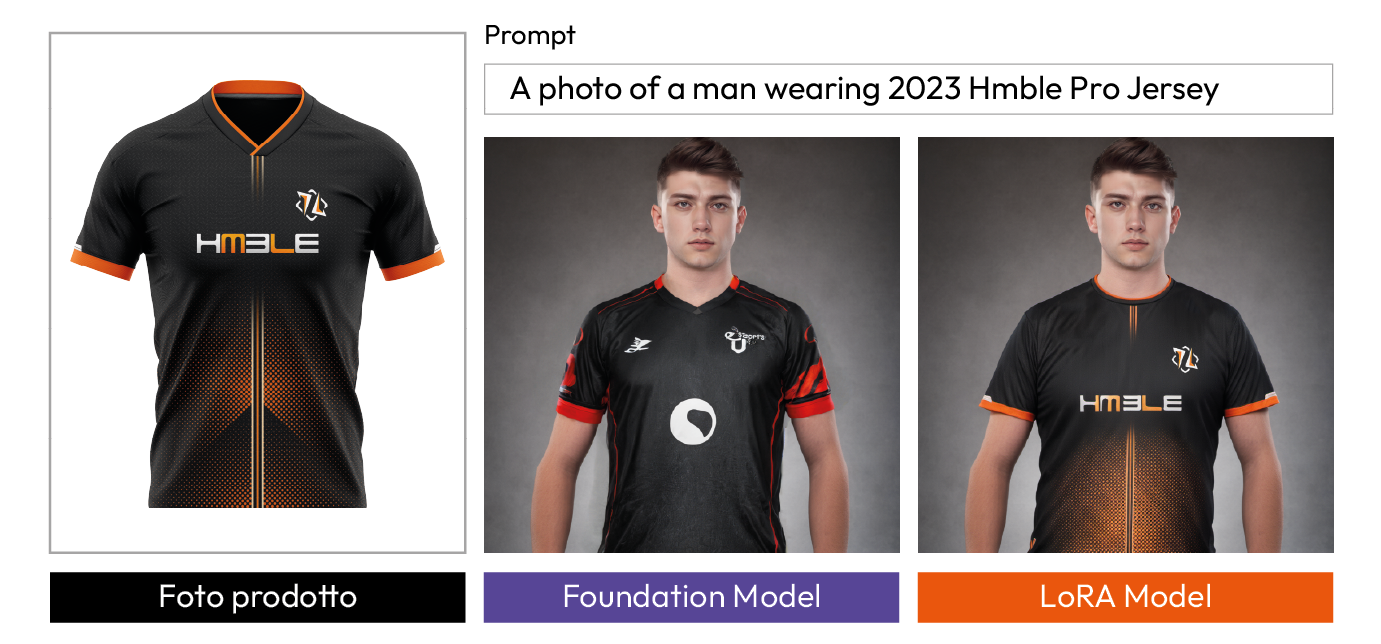

Negli ultimi mesi ne sono state proposte diverse soluzioni, una su tutte è la ricerca Low Rank Adaptation Models (LoRA). LoRA è una particolare tecnica di addestramento con la quale ottimizzare i modelli base della nota GenAI open source, Stable Diffusion (SD). Nel nostro caso, potrebbe essere utilizzata per ‘insegnare’ all’AI i vari capi di abbigliamento specifici. Questo perché, come già accennato in precedenza, se l’utente chiede al foundation model di realizzare una maglietta di e-sports questi genererà quello che più propriamente possiamo definire un “alike”, ma se io voglio una maglietta precisa, come quella in foto “Hmble Jersey 2023” dovrò affinare il modello attraverso una tecnica di fine-tuned.

3. Innovazioni e Soluzioni Recenti

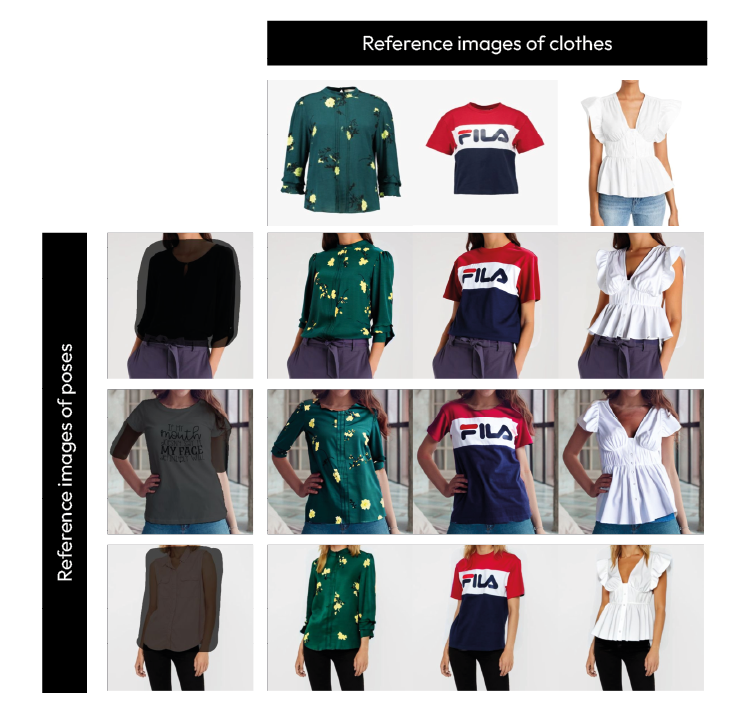

Ovviamente i LoRA non sono nè il primo nè l’unico modello attraverso cui far apprendere al modello base qualcosa di nuovo, ma hanno ottenuto notevole successo perché sfruttano file di piccole dimensioni e permettono di addestrare una rete senza particolari costi energetici o file di dimensioni spropositate. Tuttavia, se vogliamo essere precisi, i LoRA sono una tecnologia che veniva utilizzata nel “lontanissimo” 2023. L’Intelligenza Artificiale Generativa è in continuo cambiamento, basti dare un’occhiata agli ultimi due mesi: il 26 Gennaio Amazon Research pubblica il paper “Diffuse to Choose: Enriching Image Conditioned Inpainting in Latent Diffusion Model for Virtual Try-All”, un modello di intelligenza artificiale che consente di posizionare virtualmente qualsiasi articolo e-commerce in un ambiente, garantendo un’integrazione dettagliata e semanticamente coerente con ombreggiature e illuminazione realistiche; il 18 febbraio 2024 vengono annunciati i Weight-Decomposed Low-Rank Adaptation (DoRA); il 29 febbraio 2024 l’utente di twitter @dreamingtulpa scrive “Bye Bye LoRAs once again” e pubblica la nuova ricerca “Visual Style Prompting with Swapping Self-Attention”. Oltre a questi possiamo citare altri paper di rilevanza per il settore del fashion: “PhotoMaker: Customizing Realistic Human Photos via Stacked ID Embedding”, “ReplaceAnything as you want: Ultra-high quality content replacement”, “PICTURE: PhotorealistIC virtual Try-on from UnconstRained dEsigns“, “AnyDoor: Zero-shot Object-level Image Customization” e “Outfit Anyone: Ultra-high quality virtual try-on for Any Clothing and Any Person“.

Risulta quindi ovvio che la GenAI influenzerà anche il settore del fashion design, di fatto studi di consulenza di primo piano come McKinsey & Company hanno previsto che l’AI potrebbe incrementare i profitti operativi nel settore dell’abbigliamento, della moda e del lusso fino a 275 miliardi di dollari. Oltretutto, vedendo l’esponenziale sviluppo di questa tecnologia e studiando casi come quello della celebre GenAI “Midjourney”, non sembra esagerato affermare che l’AI verrà integrata commercialmente nel fashion entro la fine di questo 2024.

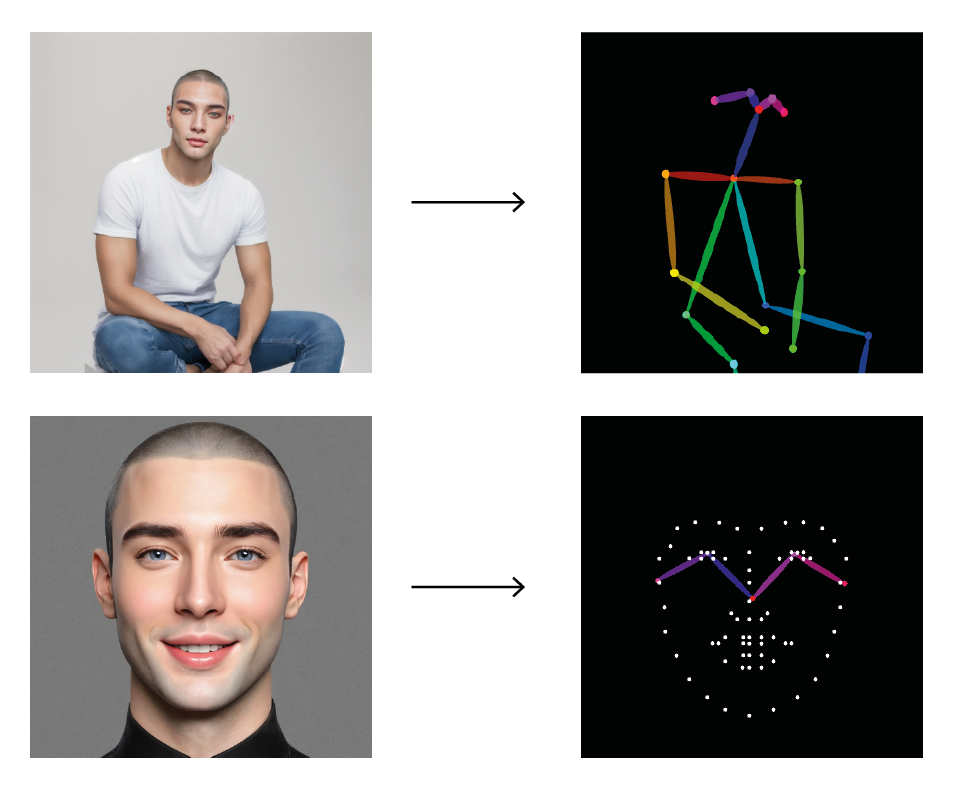

A proposito di Midjourney, per chi non ne ha mai sentito parlare, è un’applicazione che ha reso possibile la creazione di immagini iperrealistiche che spaziano dai ritratti ai paesaggi, passando per rendering di design e fotografie di moda, offrendo agli utenti non solo le prestazioni della migliore fotocamera ma anche le qualità del fotografo più talentuoso, i modelli più affascinanti, i paesaggi più mozzafiato e gli abiti più stravaganti. Questo è il motivo per cui, riferendosi all’introduzione di questa tecnologia, sentiamo continuamente ripetere: “Now human Imagination is the only limit”. Ma è davvero così? Ovviamente no. L’inganno sta nella natura “magica” della GenAI che permette di creare dal nulla semplicemente descrivendo qualcosa come avviene da decadi nei sogni di ogni essere umano. Ma… se ci fate caso, proprio la necessità di utilizzare la scrittura, attraverso il cosiddetto prompt, risulta un limite perché se “scrivere” è difficile, “descrivere” è ancora più complicato. Non a caso la storia ci insegna che la lingua migliore non è quella che parliamo, bensì l’universale lingua dei segni, dei simboli e delle immagini. In questo senso sono state sviluppate tecnologie di sostegno al prompt come IP-Adapter e ControlNet, che introducono modi per arricchire il prompt attraverso scelte visuali, come la selezione di volti specifici o la regolazione di parametri spaziali per simulare pose precise.

Questo ci dimostra come sia necessario lo sviluppo di un prompt visuale che sostituisca il prompt tradizionale come avvenne negli anni 80’ con la UI del System 1 di Apple. Insomma risulta evidente la necessaria partecipazione del designer in questo enorme sviluppo tecnologico, figura già determinante nella produzione dei sistemi che permettono l’utilizzo e quindi la commercializzazione di tali tecnologie: i wrapper.

4. Foundation Model vs Wrapper

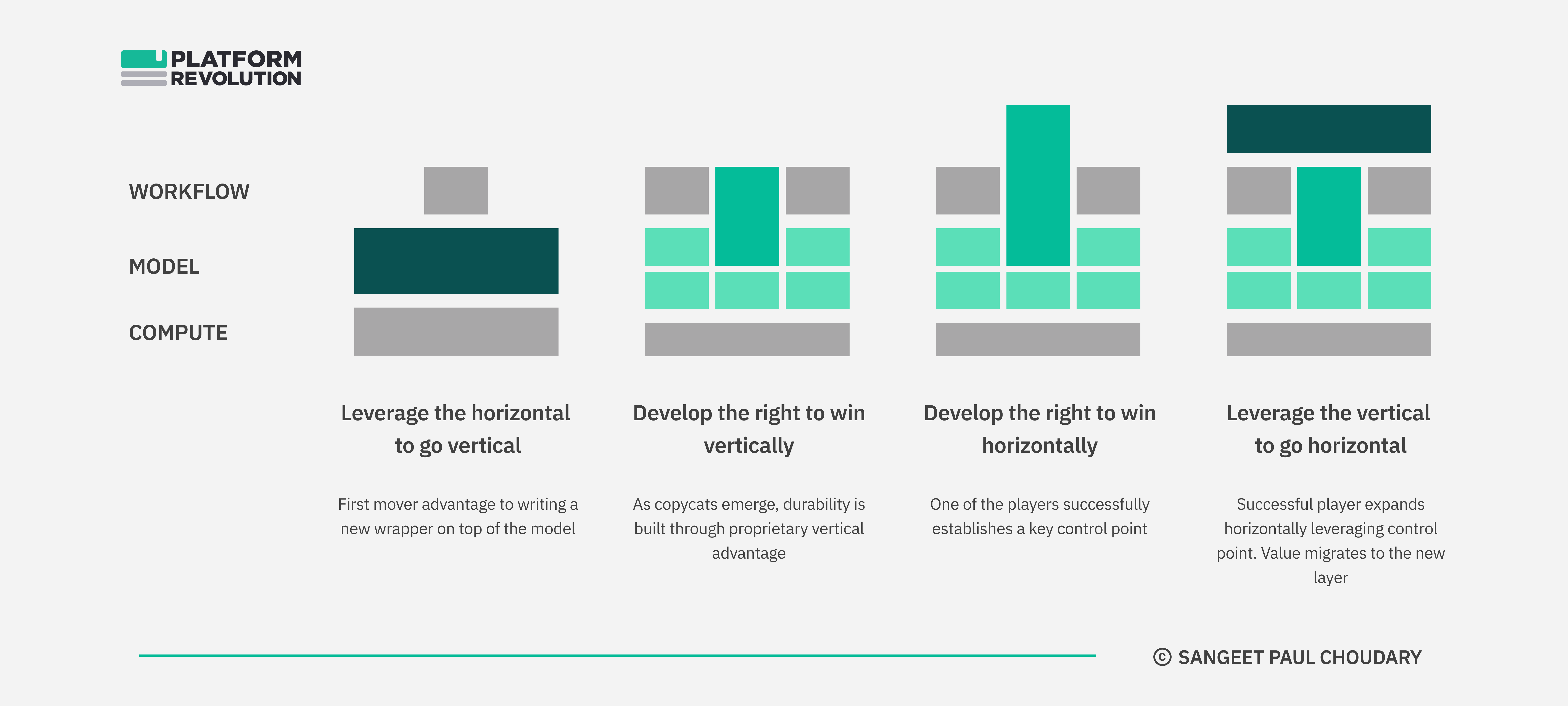

Mi preme qui ribadire una distinzione fondamentale: quella tra foundation model e wrapper. Il primo, come abbiamo già detto in precedenza, è il modello di rete neurale che è stato addestrato su database sconfinati e che riesce a svolgere tutte quelle tipologie di compiti di cui abbiamo parlato fino ad ora. SD, GPT3, Dall-e sono esempi di foundational model. Non è scorretto dire, in questo senso, che il foundation model sia la GenAI vera e propria, il fiore all’occhiello di anni di ricerca: qualcosa, insomma, per la quale dobbiamo ringraziare ingegneri elettronici, programmatori, esperti di Machine Learning. Un wrapper, invece, è letteralmente un contenitore che riveste qualcosa, nel nostro caso specifico si tratta dell’interfaccia (UI) che permette di guidare e semplificare lo specifico utilizzo di un prodotto (UX). Chat-GPT, per esempio, è un wrapper. Sono wrapper tutti i tool online che permettono all’utente inesperto di divertirsi con SD senza dover scaricare alcunché, o comprendere cosa sia un’ANN o un file LoRA. Un wrapper, in primo luogo, semplifica e rende accessibile. E’ sbagliato, però, ritenere che un wrapper si limiti esclusivamente a mediare l’esperienza, rendendo user-friendly il prodotto complesso e articolato dei programmatori. Si consideri, a tal proposito, l’esempio di SD: ad oggi, esso, può essere definito come un vero e proprio ecosistema, con un modello base al centro e miriadi di tool e add-on con i quali ottimizzare e costruire sotto-modelli specifici. L’ottimizzazione (fine-tuning) di un modello non è triviale: l’AI tende a lavorare molto meglio quando viene settorializzata, per questo i foundation model devono essere considerati solo come il punto di partenza. Non mi sembra scorretto affermare che se, da un lato, non esisterebbe wrapper senza foundation model, dall’altro quest’ultimo sarebbe quasi inutilizzabile in assenza del primo. Con questo non vogliamo sostenere che ogni wrapper sia necessario, e anzi quanto mai vero il contrario: negli ultimi mesi il web si è letteralmente riempito di copycat inutili e destinati a finire nel dimenticatoio. A tal proposito segnaliamo un’ottima disamina di Sangeet Paul Choudary. Anzitutto l’autore identifica gli ingredienti che permettono ad un Wrapper di distinguersi, non solo una veste grafica intuitiva e accattivante quindi, ma una combinazione di più fattori di vantaggio:

“a proprietary fine-tuned model, access to vertical data sets, a vertical-specific UX advantage, or some combination of all the above”.

In questo modo si realizza quella che Choudary definisce verticalizzazione rispetto al foundation model, che è orizzontale, fornisce cioè, in virtù della sua onniscienza, un valore quanto mai generico. Verticalizzare significa creare un valore che non è presente nel foundation model, significa attirare gli utenti ad utilizzare il wrapper perchè è stato progettato e ottimizzato dal designer in una maniera tale da renderlo indispensabile. Il wrapper è efficace, è facile da utilizzare, offre un workflow prolifico: insomma, attira inevitabilmente utenza. Un wrapper di questo tipo genera valore in maniera ricorsiva: una maggiore utenza implica una maggiore raccolta dati che a sua volta permette di migliorare il prodotto sempre di più. Si arriva così alla fantomatica fase quattro, quella in cui il modello ha attirato e fidelizzato talmente tanta utenza da potersi estendere orizzontalmente, diventare un hub, tutto il valore del modello fondativo ora è trasferito su quello che ormai è qualcosa di più di un wrapper, è, con la parole di Choudary, “the winner at Generative AI’”

5. Conclusione: Progetto Aracne

L’integrazione dell’IA nel fashion evidenzia l’importanza del pensiero progettuale critico nella creazione di contenuti, sottolineando come la tecnologia debba essere guidata da obiettivi chiari e considerazioni estetiche per realizzare applicazioni commerciali valide e creative. In questo contesto, sto sviluppando “Aracne“, un progetto che sfrutta l’AI generativa per la creazione di contenuti multimediali (foto e video) destinati a fini pubblicitari (social media, riviste e siti web) nel contesto del fashion design.